|

Главная Случайная страница Контакты | Мы поможем в написании вашей работы! | |

Машина Больцмана

|

|

НС Хопфилда находит локальный минимум задачи оптимизации. Для устранения этого недостатка можно использовать машину Больцмана, которая является расширением сети Хопфилда. В основе сети Больцмана лежит метод имитационного отжига (управляемого охлаждения), который является разновидностью процедуры случайного поиска.

При отвердевании расплавленного металла его температура должна уменьшаться постепенно до момента полной кристаллизации. Если процесс остывания протекает слишком быстро, то образуются нерегулярности структуры металла, которые вызывают внутренние напряжения. В результате общее энергетическое состояние тела, зависящее от внутренней напряженности, остается более высоким, чем при медленном охлаждении. Быстрая фиксация энергетического состояния тела на уровне выше нормального соответствует сходимости оптимизационного алгоритма к точке локального минимума.

Энергия состояния тела соответствует целевой функции, а абсолютный минимум – точке глобального минимума.

Метод имитации отжига представляет собой алгоритмический аналог физического процесса управляемого охлаждения. Это метод позволяет находить глобальный минимум функции нескольких переменных.

Классический алгоритм имитации отжига.

1. Запустить процесс из начальной точки w при заданной температуре Т=Тмах

2. Пока Т > 0, повторить L раз следующие действия:

· Выбрать новое решение w1 из окрестности w;

· Рассчитать изменение целевой функции ∆= E(w1) – E(w);

· Если ∆ <0 или ∆ =0, принять решение w1 = w; в противном случае ∆ > 0 принять w1 = w с вероятностью ехр (-∆ / Т) путем генерации случайного числа R из интервала (0,1) с последующим сравнением его со значением ехр (-∆ / Т); если ехр (- ∆ / Т) >R, принять новое решение w1 = w; в противном случае проигнорировать его.

3. Уменьшить температуру (Т ç T * r) с использованием коэффициента r из интервала (0,1) и вернуться к п.2

4. После снижения температуры до нулевого значения провести обучение сети любым методом.

В машине Больцмана имитационный отжиг имитируется путем вероятностного механизма перехода нейрона в новое состояние.

Pi(S)=1/(1+exp((∆Ei / Т),

где ∆Ei - изменение энергии i-го нейрона;

Т- параметр температуры;

S –состояние нейрона в момент времени t+1.

Если начать процесс релаксации с высокой температуры и постепенно снижать ее, то система придет в состояние равновесия.

Среди различных конфигураций искусственных нейронных сетей (НС) встречаются такие, при классификации которых по принципу обучения, строго говоря, не подходят ни обучение с учителем [1], ни обучение без учителя [2]. В таких сетях весовые коэффициенты синапсов рассчитываются только однажды перед началом функционирования сети на основе информации об обрабатываемых данных, и все обучение сети сводится именно к этому расчету. С одной стороны, предъявление априорной информации можно расценивать, как помощь учителя, но с другой – сеть фактически просто запоминает образцы до того, как на ее вход поступают реальные данные, и не может изменять свое поведение, поэтому говорить о звене обратной связи с "миром" (учителем) не приходится. Из сетей с подобной логикой работы наиболее известны сеть Хопфилда и сеть Хэмминга, которые обычно используются для организации ассоциативной памяти. Далее речь пойдет именно о них.

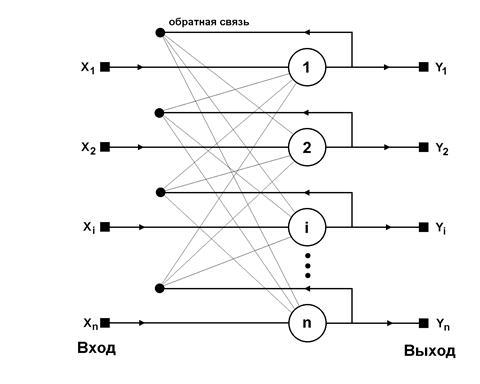

Структурная схема сети Хопфилда приведена на рис.3. Она состоит из единственного слоя нейронов, число которых является одновременно числом входов и выходов сети. Каждый нейрон связан синапсами со всеми остальными нейронами, а также имеет один входной синапс, через который осуществляется ввод сигнала. Выходные сигналы, как обычно, образуются на аксонах.

Рис.3 Структурная схема сети Хопфилда

Задача, решаемая данной сетью в качестве ассоциативной памяти, как правило, формулируется следующим образом. Известен некоторый набор двоичных сигналов (изображений, звуковых оцифровок, прочих данных, описывающих некие объекты или характеристики процессов), которые считаются образцовыми.Сеть должна уметь из произвольного неидеального сигнала, поданного на ее вход, выделить ("вспомнить" по частичной информации) соответствующий образец (если такой есть) или "дать заключение" о том, что входные данные не соответствуют ни одному из образцов. В общем случае, любой сигнал может быть описан вектором X = {xi: i=0...n-1}, n – число нейронов в сети и размерность входных и выходных векторов. Каждый элемент xi равен либо плюс единица, либо минус единица. Обозначим вектор, описывающий k-ый образец, через Xk, а его компоненты, соответственно, – xik, k=0...m-1, m – число образцов. Когда сеть распознает (или "вспомнит") какой-либо образец на основе предъявленных ей данных, ее выходы будут содержать именно его, то есть Y = Xk, где Y – вектор выходных значений сети: Y = {yi: i=0,...n-1}. В противном случае, выходной вектор не совпадет ни с одним образцовым.

Если, например, сигналы представляют собой некие изображения, то, отобразив в графическом виде данные с выхода сети, можно будет увидеть картинку, полностью совпадающую с одной из образцовых (в случае успеха) или же "вольную импровизацию" сети (в случае неудачи).

На стадии инициализации сети весовые коэффициенты синапсов устанавливаются следующим образом [3,4]:

(1)

(1)

Здесь i и j – индексы, соответственно, предсинаптического и постсинаптического нейронов; xik, xjk – i-ый и j-ый элементы вектора k-ого образца.

Алгоритм функционирования сети (p – номер итерации):

1. На входы сети подается неизвестный сигнал. Фактически его ввод осуществляется непосредственной установкой значений аксонов

yi(0) = xi , i = 0...n-1. (2)

Поэтому обозначение на схеме сети входных синапсов в явном виде носит чисто условный характер. Ноль в скобке справа от yi означает нулевую итерацию в цикле работы сети.

2. Рассчитывается новое состояние нейронов

, j=0...n-1 (3)

, j=0...n-1 (3)

и новые значения аксонов

(4)

(4)

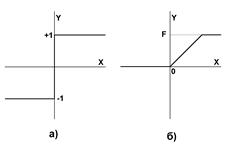

Рис.4 Активационные функции

Рис.4 Активационные функции

|

где f – активационная функция в виде скачка, приведенная на рис.4а.

3. Проверка, изменились ли выходные значения аксонов за последнюю итерацию. Если да – переход к пункту 2, иначе (если выходы застабилизировались) – конец. При этом выходной вектор представляет собой образец, наилучшим образом сочетающийся с входными данными.

Как говорилось выше, иногда сеть не может провести распознавание и выдает на выходе несуществующий образ. Это связано с проблемой ограниченности возможностей сети. Для сети Хопфилда число запоминаемых образов m не должно превышать величины, примерно равной 0.15 • n. Кроме того, если два образа А и Б сильно похожи, они, возможно, будут вызывать у сети перекрестные ассоциации, то есть предъявление на входы сети вектора А приведет к появлению на ее выходах вектора Б и наоборот.

Дата публикования: 2014-10-18; Прочитано: 1633 | Нарушение авторского права страницы | Мы поможем в написании вашей работы!