|

Главная Случайная страница Контакты | Мы поможем в написании вашей работы! | |

Двунаправленная ассоциативная память

|

|

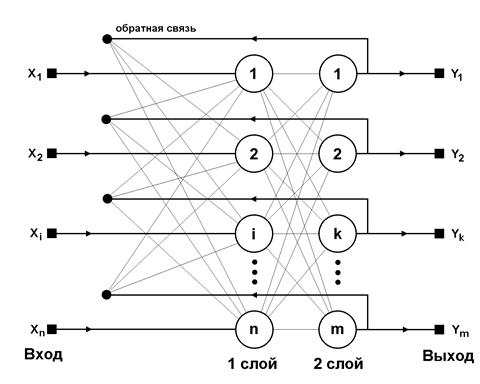

Рис.7 Структурная схема ДАП

Обсуждение сетей, реализующих ассоциативную память, было бы неполным без хотя бы краткого упоминания о двунаправленной ассоциативной памяти (ДАП). Она является логичным развитием парадигмы сети Хопфилда, к которой для этого достаточно добавить второй слой. Структура ДАП представлена на рис.5. Сеть способна запоминать пары ассоциированных друг с другом образов. Пусть пары образов записываются в виде векторов Xk = {xik:i=0...n-1} и Yk = {yjk: j=0...m-1}, k=0...r-1, где r – число пар. Подача на вход первого слоя некоторого вектора P = {pi:i=0...n-1} вызывает образование на входе второго слоя некоего другого вектора Q = {qj:j=0...m‑1}, который затем снова поступает на вход первого слоя. При каждом таком цикле вектора на выходах обоих слоев приближаются к паре образцовых векторов, первый из которых – X – наиболее походит на P, который был подан на вход сети в самом начале, а второй – Y – ассоциирован с ним. Ассоциации между векторами кодируются в весовой матрице W(1) первого слоя. Весовая матрица второго слоя W(2) равна транспонированной первой (W(1))T. Процесс обучения, также как и в случае сети Хопфилда, заключается в предварительном расчете элементов матрицы W (и соответственно WT) по формуле:

(11)

(11)

Эта формула является развернутой записью матричного уравнения

(12)

(12)

для частного случая, когда образы записаны в виде векторов, при этом произведение двух матриц размером соответственно [n*1] и [1*m] приводит к (11).

Рассмотрим пример. Требуется обучить НС с целью запоминания трех пар векторов.

| Вектор А | Вектор А’ | Вектор АT | Вектор B | Вектор B’ |

| 1 -1 -1 | 1 -1 -1 | -1 -1 1 | ||

| -1 1 -1 | -1 1 -1 | -1 1 -1 | ||

| -1 -1 1 | -1 -1 1 | 1 -1 -1 |

Вычисляется вектор W= АT *B’

| Вектор W | Вектор Wt |

| -1 -1 3 | -1 -1 3 |

| -1 3 -1 | -1 3 -1 |

| 3 -1 -1 | 3 -1 -1 |

Вычисляется выходной вектор O=A*Wt

Для А1=(100) O1=(100)t

| -1 -1 3 |

| -1 3 -1 |

| 3 -1 -1 |

O1=(-1 -1 3)

Выполним преобразования b1=1 если Оi>0 bi>0 если Оi<0: О1=(001)

ДАП имеет ограничения на максимальное количество хранимых ассоциаций, при превышении которого сеть может вырабатывать неверный прогноз.

В настоящее время разработано много разновидностей ДАП:

1) непрерывная ДАП с сигмоидами в качестве активационной функции;

2) адаптивная ДАП с изменением весов в процессе функционирования сети;

3) конкурирующая ДАП с конкуренцией нейронов внутри каждого слоя.

Достоинства ДАП

ДАП напоминает организацию памяти человека, которая часто является ассоциативной, т.е. один предмет напоминает о другом, а другой о третьем. Если позволять нашим мыслям, они будут перемещаться от предмета к предмету по цепочке умственных ассоциаций. Кроме того, возможно использование к ассоциациям для восстановления забытых образов. Т.е. ассоциированный образ может быть завершен или исправлен, но не может быть ассоциирован с другим образом. К достоинствам относится:

1) простота реализации ДАП, которую можно реализовать на СБИС;

2) совместимость с аналоговыми схемами и оптическими системами;

3) быстрая сходимость процесса обучения.

В заключении можно сделать следующее обобщение. Сети Хопфилда, Хэмминга и ДАП позволяют просто и эффективно разрешить задачу воссоздания образов по неполной и искаженной информации. Невысокая емкость сетей (число запоминаемых образов) объясняется тем, что, сети не просто запоминают образы, а позволяют проводить их обобщение, например, с помощью сети Хэмминга возможна классификация по критерию максимального правдоподобия [3]. Вместе с тем, легкость построения программных и аппаратных моделей делают эти сети привлекательными для многих применений.

Литература

С. Короткий, Нейронные сети: алгоритм обратного распространения.

С. Короткий, Нейронные сети: обучение без учителя.

Artificial Neural Networks: Concepts and Theory, IEEE Computer Society Press, 1992.

Ф.Уоссермен, Нейрокомпьютерная техника, М.,Мир, 1992.

Головко В.А. нейронные сети: организация и применение. Кн.4: Учеб. пособие для вузов /Общая ред. А.И. Галушкина.-М.: ИПРЖР, 2001-256с.

Круглов В.В., Борисов В.В. Искусственные нейронные сети. Теория и практика.-М.: Горячая линия – Телеком, 2001.-382с.

Дата публикования: 2014-10-18; Прочитано: 1520 | Нарушение авторского права страницы | Мы поможем в написании вашей работы!