|

Главная Случайная страница Контакты | Мы поможем в написании вашей работы! | |

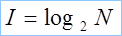

Расчет количества информации по Хартли

|

|

Частный случай формулы Шеннона для равновероятных событий:

|

|

где I – количество информации, бит

N – число возможных состояний системы

Чем большее количество состояний мог принимать объект, тем большее количество информации несет данное сообщение.

Коэффициент (степень) информативности сообщения определяется соотношением количества информации к объему данных, т.е.

причем 0 < Y < 1

С увеличением Y уменьшается объем работы по преобразованию данных в системе. Поэтому стремятся к повышению информативности, для чего разрабатывают специальные методы оптимального кодирования информации.

Человек, бросающий монету и наблюдающий за ее падением, получает определенную информацию. Его интересует ответ - какой стороной упадет монета. Неопределенность после того, как монета упадет, будет равна нулю, т.е. будет достигнута полная ясность. Какой же прогноз можно сделать до бросания монеты? Обе стороны монеты "равноправны", поэтому одинаково вероятно, что выпадет как одна, так и другая сторона. Начальная неопределенность равна 1. Конечная неопределенность после падения монеты равна 0.

Дата публикования: 2014-11-18; Прочитано: 324 | Нарушение авторского права страницы | Мы поможем в написании вашей работы!